Apple finalmente svela il suo progetto di realtà aumentata… e a dire il vero altre due o tre cosette

da Milano – C’era molta attesa per l’appuntamento WWDC di Apple. Sapendo ormai tutti che non sarebbe stato presentato alcun iPhone, la bramosia era per vedere finalmente lo strumento di sviluppo per la realtà aumentata marcata Apple.

Curiosità alimentata anche dall’acquisizione, avvenuta qualche tempo fa, di Metaio, allora la migliore piattaforma AR in circolazione (secondo il mio personalissimo parere). La domanda legittima era: ma come avranno usato la promettentissima tecnologia di Metaio all’interno dell’SDK di Apple? La risposta è ARKIT, un modulo che racchiude la sintesi dell’idea di realtà aumentata secondo Apple, ed è un approccio piuttosto interessante. Il kit di sviluppo si basa sulla tecnologia Visual Inertial Odometry, la stessa di Tango/Google, tanto per intenderci.

Semplifichiamo? Si tratta di un sistema che individua i piani orizzontale e verticali, quindi, all’interno di questa dimensione colloca in automatico un oggetto tridimensionale sul piano verticale, cercando la perfetta integrazione in  termini di proporzioni. Per capire come funziona la cosa migliore è scaricare l’esempio/progetto fornito da Apple per gli sviluppatori, già compilato e con oggetti 3D precaricati.

termini di proporzioni. Per capire come funziona la cosa migliore è scaricare l’esempio/progetto fornito da Apple per gli sviluppatori, già compilato e con oggetti 3D precaricati.

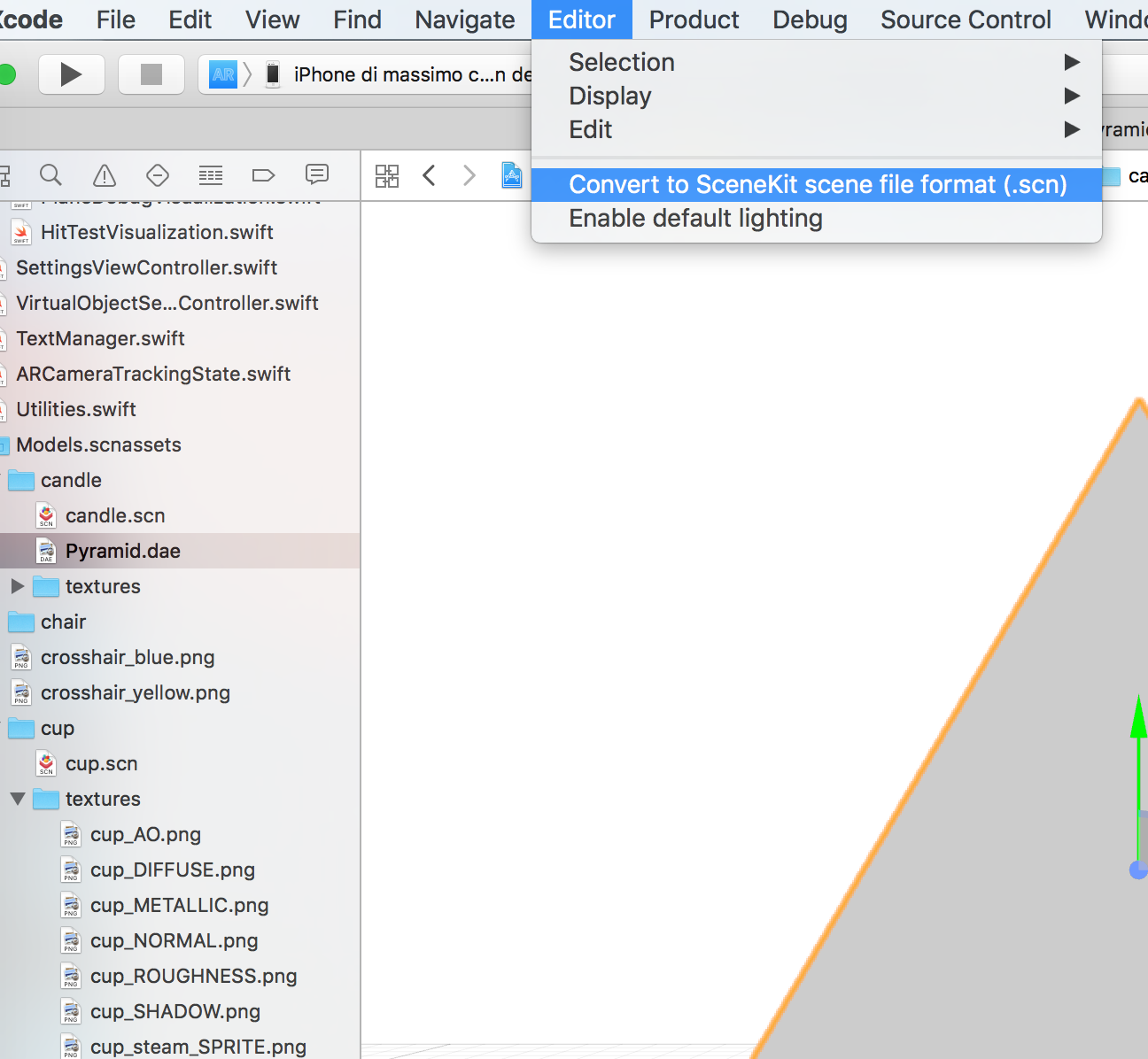

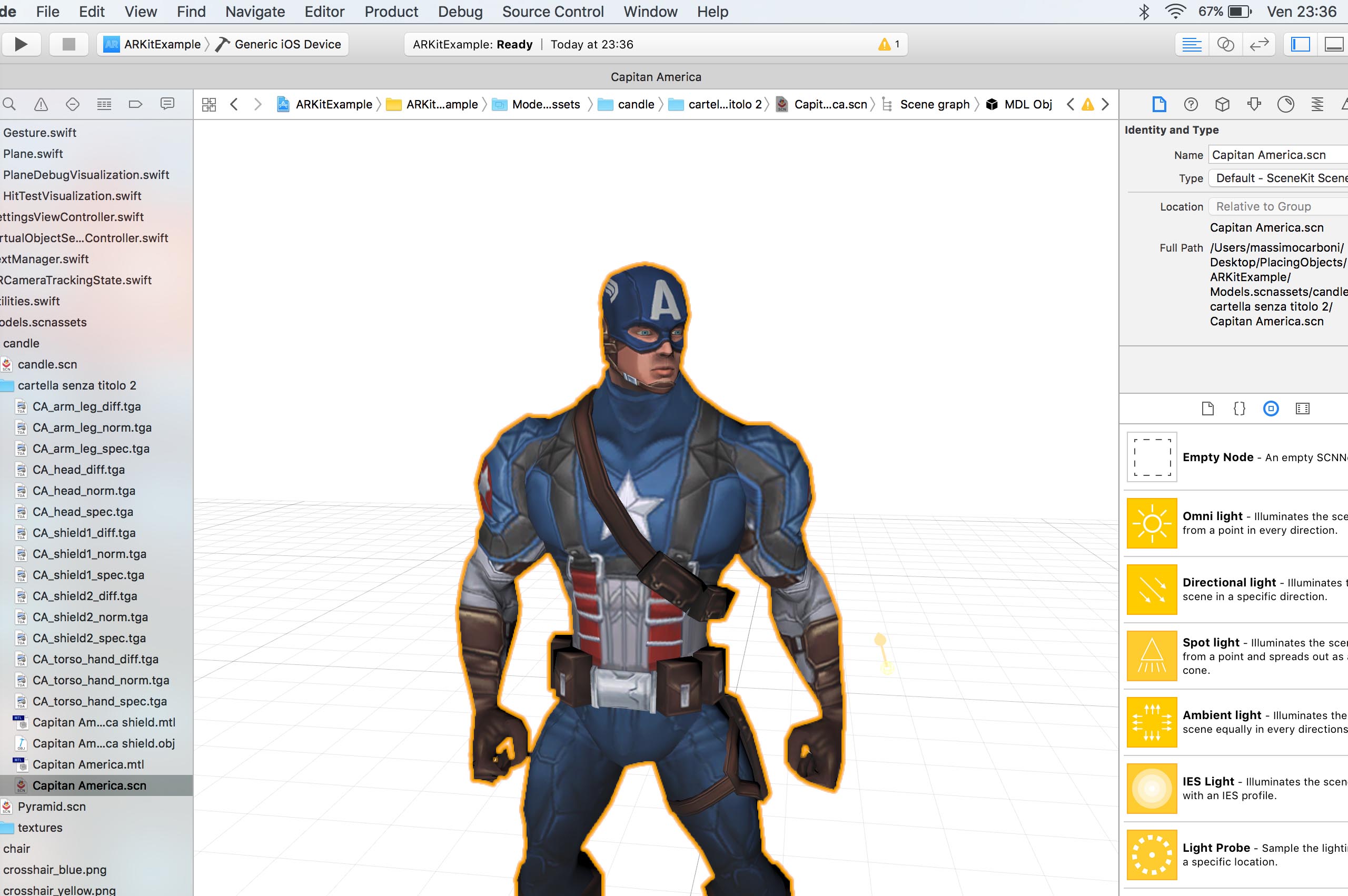

Si compila solo su device fisico, come tutti gli ambienti di sviluppo di realtà aumentata, e solo su device con installato IOS 11. L’ambiente in .swift si presenta piuttosto familiare per chi è abituato a sviluppare con Xcode, gli oggetti integrati sono in .scn, questo determina un minimo di smarrimento iniziale, però le texture che accompagnano l’oggetto 3D sono nei formati familiari.

Quindi la domanda è: come importare i modelli?

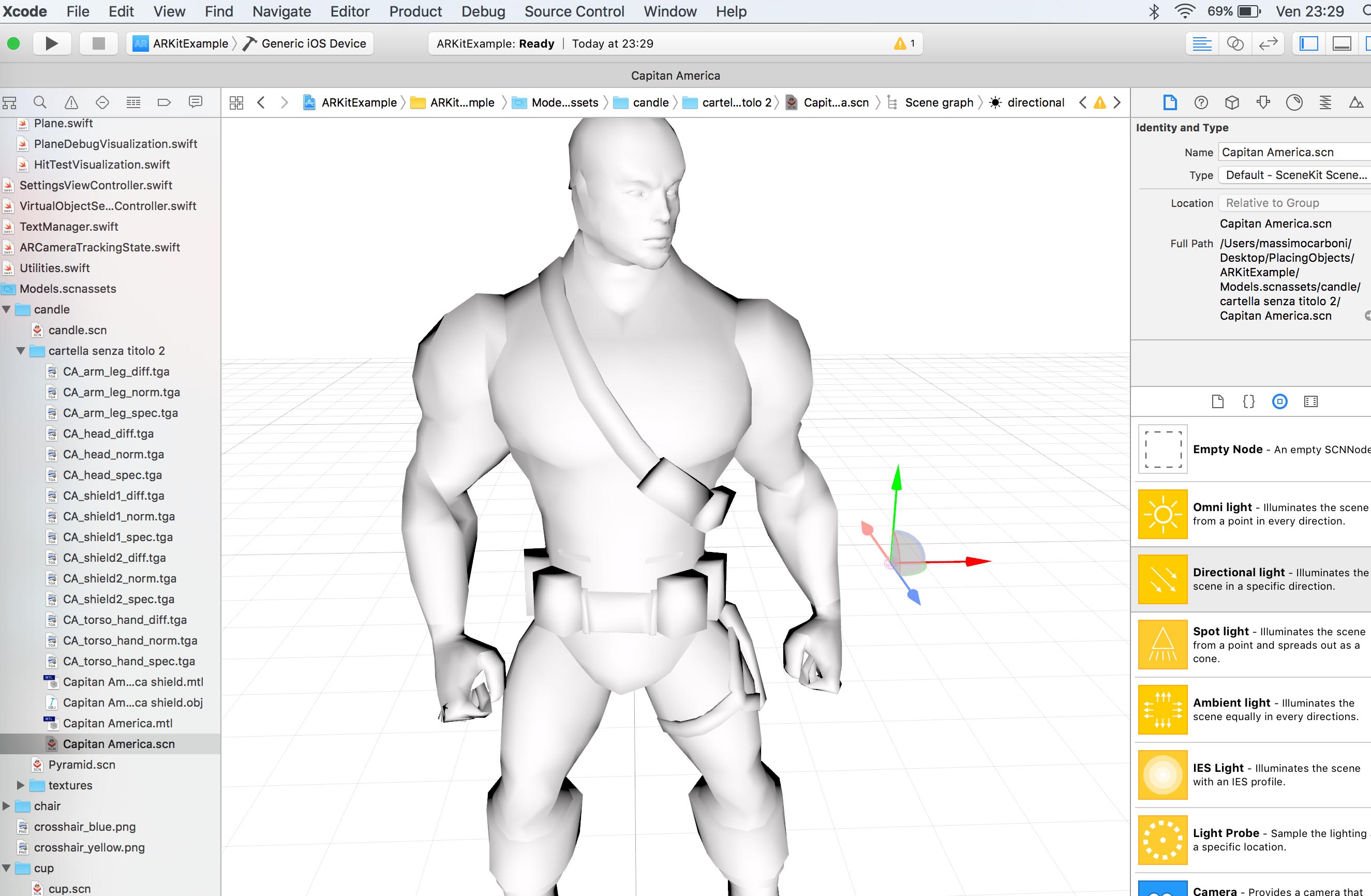

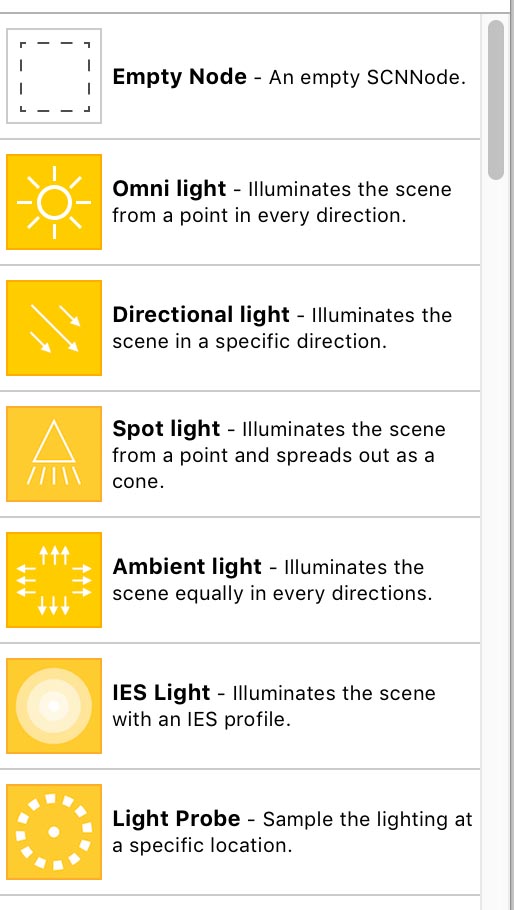

Davvero semplice: ho provato a inserire un modello in Collada (.dae) e un .obj. Inseriti in pochi secondi. Poi nel Menu>Editor è presente una voce “Convert to SceneKit scene file format (.snc)”, con cui convertirli nel formato nativo dell’ARKIT. Le luci si aggiungono con  drag e drop dall’inspector di destra e le texture vengono applicate sempre con un semplice trascinamento, il risultato è davvero sorprendente per la velocità con cui viene ottenuto. Sembra di usare Unity o Unreal, ma molto più veloce e intuitivo. Wow!. A dire il vero non ritrovo molto di Metaio in questo esempio, la compagnia tedesca aveva messo a punto un riconoscimento di oggetti/marker basato su algoritmo SLAM estremamente efficace: si inquadra un’immagine, si attiva un contenuto, il contenuto rimane “incollato” all’immagine con effetto tracking.

drag e drop dall’inspector di destra e le texture vengono applicate sempre con un semplice trascinamento, il risultato è davvero sorprendente per la velocità con cui viene ottenuto. Sembra di usare Unity o Unreal, ma molto più veloce e intuitivo. Wow!. A dire il vero non ritrovo molto di Metaio in questo esempio, la compagnia tedesca aveva messo a punto un riconoscimento di oggetti/marker basato su algoritmo SLAM estremamente efficace: si inquadra un’immagine, si attiva un contenuto, il contenuto rimane “incollato” all’immagine con effetto tracking.

Quello di Apple, invece, è l’approccio di Tango/Google che si dimensiona sugli ambienti più che sui marker di attivazione. Se volete un esempio di questo tipo di tecnologia scaricate Pokemon Go: la geolocalizzazione fa scattare  l’attivazione dell’oggetto 3D e la tecnologia Visual Inertial Odometry lo allinea al terreno. Se poi volete creare un’app di realtà aumentata tipo Ikea, con cui posizionare i mobili o complementi di arredo in una stanza, questo è lo strumento

l’attivazione dell’oggetto 3D e la tecnologia Visual Inertial Odometry lo allinea al terreno. Se poi volete creare un’app di realtà aumentata tipo Ikea, con cui posizionare i mobili o complementi di arredo in una stanza, questo è lo strumento  ideale. Sarà divertente capire se diventerà uno standard di sviluppo, oppure se AR e VR prenderanno altre strade inaspettate.

ideale. Sarà divertente capire se diventerà uno standard di sviluppo, oppure se AR e VR prenderanno altre strade inaspettate.

Chissà.

Poi Apple ha presentato tantissimo hardware. A dire il vero ha rinnovato quasi tutte le linee. Troppo lungo parlarne, potete tranquillamente approfondire sul sito di Apple. L’unico “oggetto” che davveroincuriosisce è l’iMac Pro, una “belva”, in termini prestazioni, pensato forse per prepensionare il Mac Pro. Peccato che i prezzi non siano ancora dichiarati sullo Store Italia.